2023 NeurIPS에 투고된 논문으로, VLM(Vision-Language Model)중 뛰어난 성능을 보인 모델인 LLaVA에 대한 논문입니다.

두 가지 버전이 있는데, 개선된 버전인 LLaVA 1.5를 기준으로 합니다.

LLaVA

Based on the COCO dataset, we interact with language-only GPT-4, and collect 158K unique language-image instruction-following samples in total, including 58K in conversations, 23K in detailed description, and 77k in complex reasoning, respectively. Please

llava-vl.github.io

1. Introduction

Large multimodal model(LMMs)는 보편적인 조수 모델로서 유망적인 모델이 되었습니다. 특히 현재는 LMMs에 대해 visual instruction tuning*이 주요 연구 주제가 되고 있는데, 본 연구 모델의 전신인 LLaVA나 MiniGPT-4와 같은 모델이 이미 그 성능을 잘 보여주고 있습니다.

* visual instruction : 이미지 기반 사용자 지시. 이미지가 입력값 중 일부로 주어짐 (e.g. 사진 설명)

하지만 모델을 어떤 방식으로 학습시켜야 보편적인 목적에 맞은 모델로 만들 수 있을지는 아직까지 명료하게 해결되지 않았습니다. 예를 들어, 현재 LLaVA는 대화형 이미지 추론에 탁월한 성능을보이는 한편, 단답형 반응이 필요한 VQA* 벤치마크에서는 InstructBLIP 모델이 뛰어난 성능을 보이는 경우가 있습니다. 왜 이런 결과가 나오는지는 아직까지도 명확하지 않고, 추측만 존재할 뿐입니다.

* VQA(Visual Quenstion Answering) : 이미지 기반 질문 작업. 이미지 + 관련 질문 조합의 입력값에 대해 적절한 응답을 하는 작업

본 연구는 통제된 조건에서 LMMs의 설계 선택지를 체계적으로 분석한 최초의 연구를 제시합니다. 이 연구는 LLaVA 모델에서부터 시작하여 입력(input), 모델 구조(model), 데이터(data)의 관점에서 설계 지침(road map)을 구축합니다.

먼저, 원래 LLaVA의 fully-connected vision-language connector 구조가 실제로 강력한 구조임을 다시 한번 상기시키며, 이를 기반으로 두 가지 기법을 추가하여 개선했다고 합니다.

- MLP 기반의 cross-modal connector

- VQA 기반의 학술적 작업과 관련한 데이터 도입

이 두 가지 기법은 기존의 LLaVA모델과 독립적이어서(orthogonal), 기존 LLaVA모델에 바로 추가해도 문제가 없으며 multimodal 성능이 더 향상되었다고 합니다. 게다가 다른 모델들(InstructBLIP, Qwen-VL 등)과 달리 LLaVA는 600K 정도 크기의 image-text 데이터만 학습시키면 될 정도로 간단한 구조를 가지고 있습니다. 그렇기 때문에 A100 8장을 이용해 하루만 학습시켜도 SotA 성능을 보일 수 있다고 합니다.

그리고, 본 연구는 기존 multimodal 모델(LLaVA 포함)들의 주로 주목할 만한 특징들도 탐색해 보았습니다. 아래는 공통적으로 찾은 특징들입니다.

1.1. Scaling to high-resolution image inputs

LLaVA는 고해상도의 이미지를 입력으로 받을 때, 이미지를 격자 형태로 잘라서 처리합니다. 따라서 입력하는 이미지의 해상도가 높아질수록, 모델의 성능이 높아지고 환각효과(hallucination)가 감소함을 보았습니다.

1.2. Compositional capabilities

조합적인 일반화 능력(generalizing to compositional)에 대해 이야기합니다. 예를 들어, 긴 언어 형식 데이터와 짧은 시각 형식 데이터를 함께 학습시킬 때 여러가지의 질문에 대한 모델의 응답 성능이 향상되는 방식입니다.

1.3. Data efficiency

LLaVA의 학습데이터를 75% 까지 줄여도 모델성능에 큰 영향을 주지 않았습니다. 이는 데이터셋을 더 효율적으로 압축시킬 수 있는 가능성을 제시합니다.

1.4. Data scaling

데이터의 세분화도(granularity)를 조절함에 따라, 환각효과 없이 모델의 성능이 높아짐을 확인했습니다.

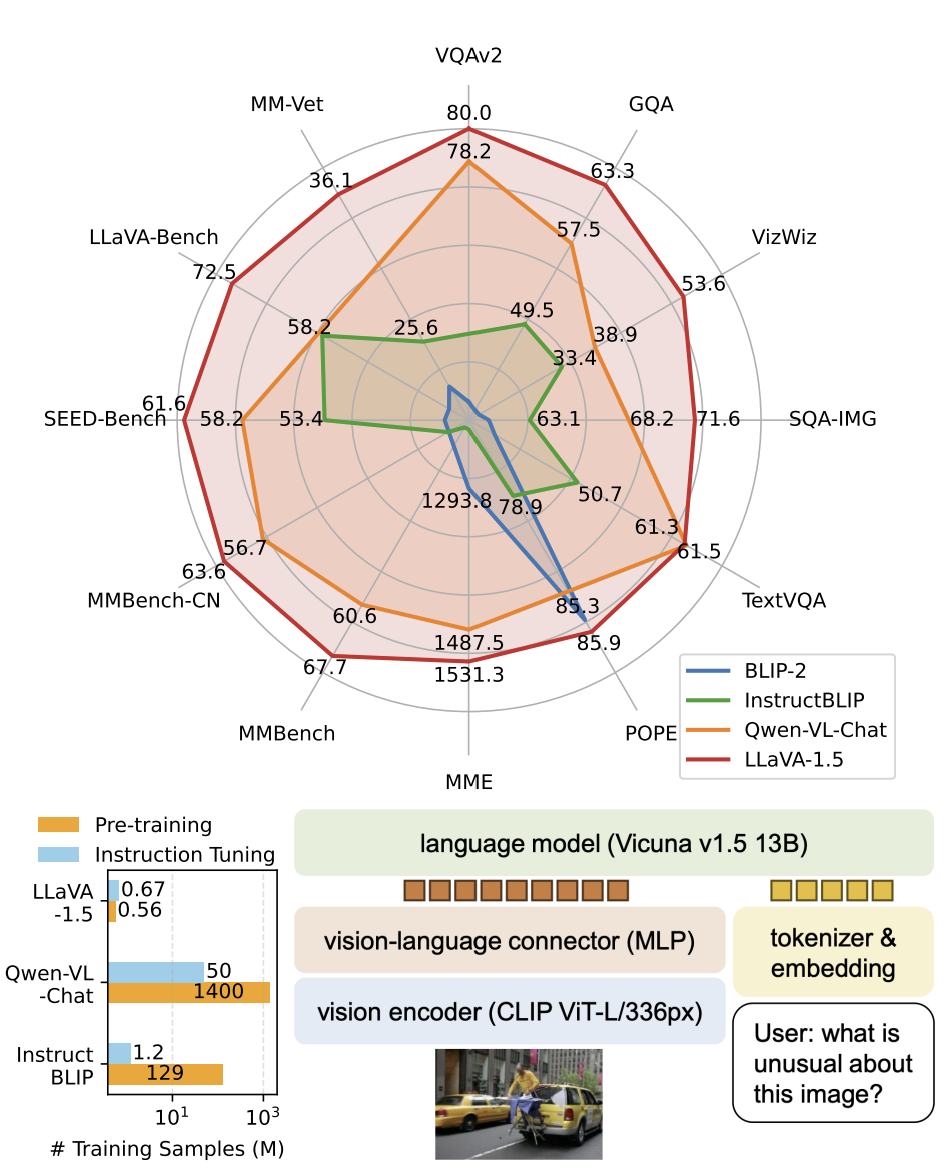

결과적으로, 본 연구에서는 LMMs에 대해 간단하지만 효과적인 접근방식에 대해 조사하여 개선된 모델인 LLaVA-1.5를 소개합니다. 이는 기존의 해결되지 않은 LMMs들의 특징을 기반으로 개선되었으며, 11개 작업에 대해 StoA 성능을 발휘하게 되었습니다.

2. Related Work

- Instruction-following large multimodal models (LMMs)

- Multimodal instruction-following data

3. Approach

3.1. Preliminaries

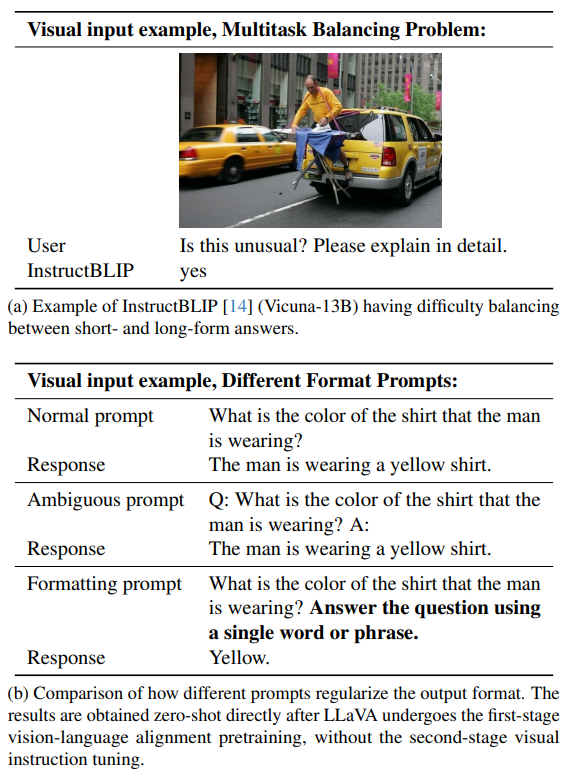

LLaVA는 visual encoder(이미지에서 추출한 특징)와 LLM(LLaMA) 사이를 하나의 선형계층(linear layer)로 연결하는 모델입니다. LLaVA는 다양한 visual instruction에 대해 뛰어난 성능을 보이지만, yes/no 질문에서 항상 yes를 답으로 내놓는 등 단답을 요구하는 학술적인 벤치마크에서는 좋지않은 성능을 보입니다.

InstructBLIP는 Qformer를 미리 학습 시킨 뒤 visual instruction과 관련된 부분에서만 fintuning을 시켜 만듭니다. 해당 모델은 VQA등 학술목적의 데이터셋에 최적의 성능을 보이지만, 반대로 실생활의 대화 작업에서는 LLaVA만큼의 성능을 보이지 않습니다.

3.2. Response Format Prompting

본 연구는 질문에 대한 응답에서 단문 형태와 장문 형태간 균형이 맞지 않는 이유는 아래와 같다고 말합니다.

- 다소 모호한 응답 형식 : 모델이 학습하는 프롬프트 형태가 단순히 $Q: {question} \quad A: {answer}$와 같은 형태이면 우리는 응답을 원하는 형식으로 유도할 수 없습니다. 이는 자연스러운 형식의 응답보다는 단문 형태의 응답을 하도록 과적합될 것입니다.

- LLM을 fintuning하지 않음 : InstructBLIP 모델의 경우, Qformer만 fintuning하는 것이 문제가 될 수 있습니다. 이는 Qformer의 출력값(visual token)이 LLM의 출력 길이(단문 or 장문)를 결정지어야 한다는 뜻인데, Qformer는 다른 LLMs 모델만큼 용량이 충분하지 않아 그런 작업에는 적절하지 않습니다.

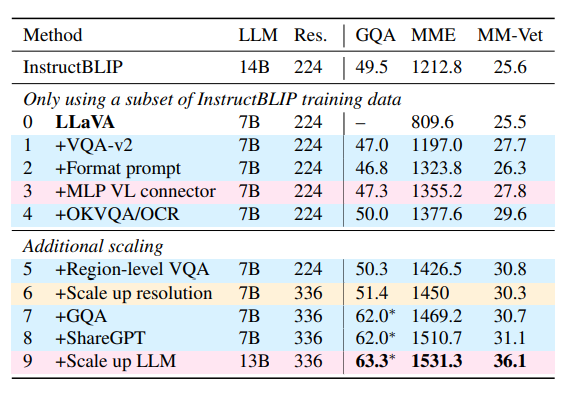

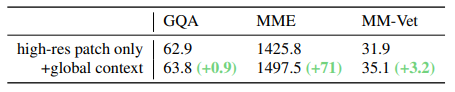

따라서, 본 연구는 한 가지의 응답 형식을 지정하여 질문 끝에 프롬프트로 추가하였습니다. 가령, 단답형 VQA 질문에는 끝에 "Anwer the question using a single word or phrase"를 추가하는 방식입니다. 실제로 LLM이 이런 방식의 프롬프트를 포함하여 fintuning 되면, LLaVA가 사용자의 의도에 맞는 적절한 응답 형식을 반환하는 것을 확인하였습니다(표 1). 또한 LLaVA에 VQAv2를 적용했을 때 MME 점수가 비약적으로 상승하는 것도 확인할 수 있습니다(표 2).

3.3. Scaling the Data and Model

3.3.1. MLP vision-language connector

기존 모델인 LLaVA는 visual encoder(이미지에서 추출한 특징)와 LLM(LLaMA) 사이를 선형사영(linear projection)으로 구성하였습니다. 대신, 이를 이중 계층의 MLP로 구성하면 그 성능을 향상시킬 수 있음을 확인했습니다.

3.3.2. Academic task oriented data

VQA 데이터셋을 추가로 적용하는 단계입니다. 우선 InstructBLIP에서 쓰이던 네 가지의 데이터셋(OKVQA, A-OKVQA, OCR*VQA, TextCaps)을 추가합니다. [표 2]에서 보듯, 이들만 추가해도(0 - 4) 유의미한 성능향상이 보입니다.

* OCR(Optical Character Recognition) : 광학 문자 인식. 이미지 속에 포함된 텍스트를 인식하여 추출하는 작업

3.3.3. Additional scaling

- visual encoder를 CLIP-ViT-L-336px(CLIP에서 가능한 가장 큰 해상도)로 바꾸어 LLM이 이미지를 더 잘 볼 수 있도록 해상도를 높였습니다.

- GQA* 데이터셋을 추가하여 추가적인 시각 지식을 부여해 주었습니다.

- ShareGPT 모델을 사용하고 LLM 크기를 13B로 늘렸습니다.

* GQA(Grouped Query Attention) : 보다 높은 수준의 추론능력을 요하는 VQA 데이터셋

3.3.4. LLaVA-1.5

여기까지의 모든 개선사항이 적용된 모델([표 2]에서 8, 9번)을 LLaVA-1.5로 명명합니다.

3.3.5. Computational cost

LLaVA-1.5.의 학습은 LLaVA와 같은 조건에서 진행되었습니다. 다만 입력 이미지가 $336^2$까지 커졌기 때문에, 기존 LLaVA보다 두 배의 시간이 더 소요됩니다.

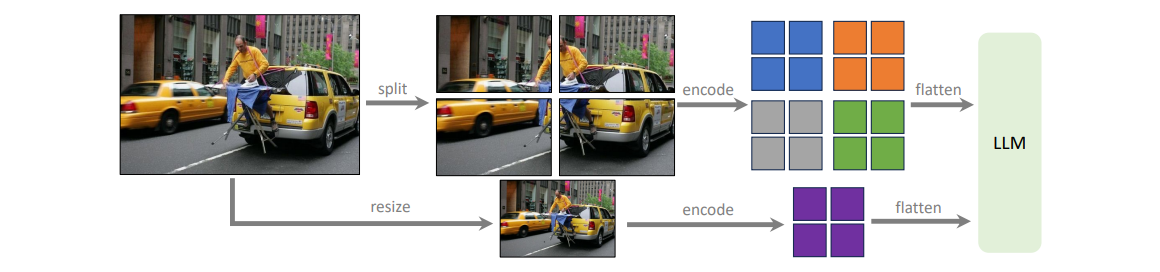

3.4. Scaling to Higher Resolutions

3.3절에서처럼 입력 이미지의 해상도를 높일수록 모델의 성능이 향상되지만, CLIP의 vision encoder의 크기가 $336^2$까지로 제한되기 때문에, 해상도를 계속 키울 수는 없습니다.

또 다른 vision encoder인 ViT의 경우 positional embedding 보간법을 이용하여 해상도르 높일 수 있긴 한데, ViT는 대규모의 image-text 데이터셋이 필요하며 LLM이 받을 수 있는 정해진 크기의 해상도만 유효하다는 단점이 있습니다.

그리하여 본 연구에서는 입력 이미지를 작은 이미지들로 쪼개어 vision encoder가 처리할 수 있도록 하였습니다. 이렇게 쪼개진 작은 이미지들이 feature map으로 변환되면, 이들을 하나의 큰 feature map으로 만들어 LLM에게 전달하는 식입니다. 여기서 연산을 줄이기 위해 원본을 downsampling한 이미지도 feature map에 합쳐줍니다. 이 모델을 LLaVA-1.5-HD라고 명명합니다.

4. Empirical Evaluation

4.1. Benchmarks

본 연구에서는 아래 총 12개의 벤치마크들이 평가에 사용되었습니다.

| 벤치마크 | 평가 항목 |

| VQA-v2 | open-ended short answering |

| GQA | open-ended short answering |

| VizWiz | zero-shot generalization on visual questions answering |

| ScienceQA | zero-shot generalization on scientific questions answering |

| TextVQA | text-rich visual question answering |

| POPE | degree of hallucination |

| MME-Perception | yes/no question answering |

| MMBench | answer robutness on multiple choice answers |

| MMBench-CN | Chinese-translated version of MMBench |

| SEED-Bench | images and videos with multiple choice |

| LLaVA-Bench-in-the-Wild | visual conversations on a diverse range of tasks |

| MM-Vet | visual conversations on a diverse range of tasks |

4.2. Results

LLaVA-1.5가 다른 모델들보다 더 적은 데이터를 학습했음에도, 더 뛰어난 성능을 보임을 확인할 수 있습니다. 이는 visual instruction tuning이 LMMs 성능에 중요한 역할을 한다는 것, 그리고 데이터셋의 양이 항상 LMMs의 성능을 좌우하는 것은 아니라는 것을 시사합니다.

또한 고해상도 이미지에 대해 global context(3.4절)의 여부가 성능에 어떤 영향을 주는지 또한 확인할 수 있습니다.

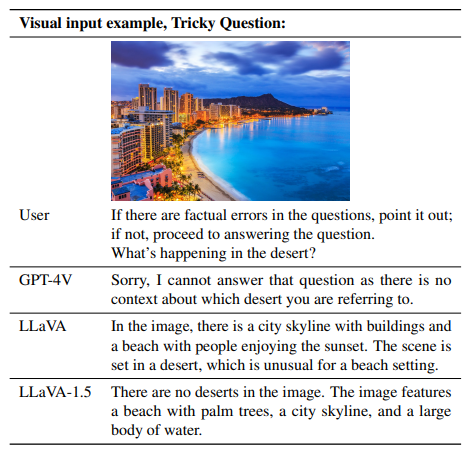

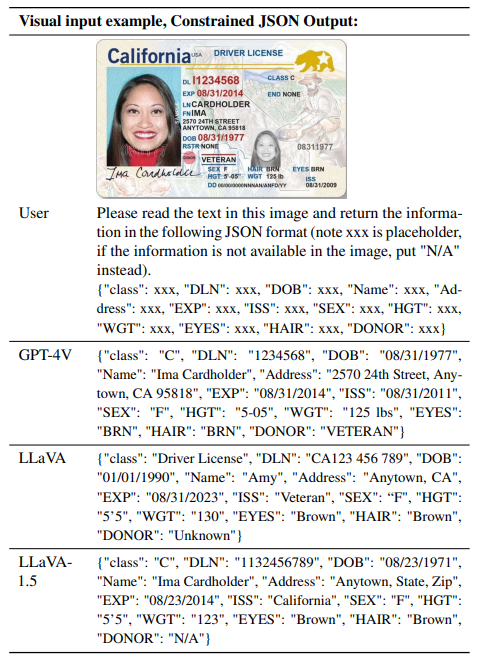

4.3. Emerging Properties

4.3.1. Format instruction generalization

LLaVA-1.5는 몇 가지의 출력 지침만을 학습했지만, 그 보다 더 보편적인 지시도 따를 수 있게 되었습니다. 가령 VizWiz에서는 명확하게 답할 수 없는 지시에 대해 "Unanwerable"이라는 응답을 요구하는데, LLaVA-1.5s는 이를 잘 수행하는 것을 보여줍니다. 이렇게 LLaVA-1.5는 간단한 지시(prompt)만으로도 새로운 포맷에 적응할 수 있는 지침 일반화 능력을 보여줍니다.

4.3.2. Multilingual multimodal capability

LLaVA-1.5는 다국어 multimodal 지시를 위해 따로 fintuning된 적이 없음에도 다국어 지시를 잘 따르는 것을 볼 수 있는데, 학습과정에서 다국어 지시가 포함된 ShareGPT 데이터셋을 학습했기 때문으로 보입니다.

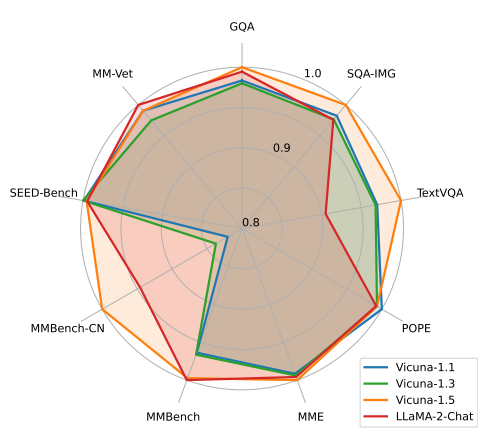

4.4. Ablation on LLM Choices

LLM 자체의 성능 또한 모델에 영향을 줄 수 있습니다. 따라서 본 연구에서는 서로 다른 LLM 모델(Vicuna, LLaMA)을 사용하여 ablation study를 진행했습니다. LLaMA-based는 Vicuna-v1.1과 Vicuna-v1.3을, LLaMA-2-based는Vicuna-v1.5와 LLaMA-2-Chat을 사용합니다. Vicuna는 지도학습 기반의 fintuning만 진행되었지만(SFT), LLaMA-2-Chat은 인간 피드백 기반의 강화학습으로 학습된 모델(RLHF)입니다.

그림과 같이 LLaMA-2-based가 더 뛰어난 성능을 보입니다. 또한 비슷한 성능을 보이는 Vicuna-1.5와 LLaMA-2-Chat이 MMBench-CN에서는 명확한 차이가 나는데, 이는 LLM의 학습 언어가 벤치마크에 미치는 영향을 보여줍니다.

5. Open Problems in LMMs

5.1. Data Efficiency

LLaVA-1.5.가 InstructBLIP에 비해 데이터 효율이 좋아도, 여전히 LLaVA에 비해서 두 배의 시간이 걸립니다. 이를 해결하기 위해 0.1 - 0.5 사이의 무작위 값으로 학습데이터에 subsampling을 적용하는 실험을 해보았습니다.

실험 결과 50%까지 데이터셋을 줄였음에도 그 성능의 차이가 거의 없고, 오히려 MMBench의 경우 올라가기도 했음을 확인했습니다. 이는 데이터 효율을 더 낼 수 있는 여지를 보여줍니다.

5.2. Rethinking Hallucination in LMMs

LMMs에서 환각은 주로 오류 혹은 학습하는 데이터셋에서 비롯된 것으로 생각합니다. 본 연구에서 입력 이미지의 해상도가 높아졌을 때 환각 현상이 줄어든 것으로 보아, 데이터셋 자체에 오류가 있어도 LMMs은 어느정도 안전하다고도 볼 수 있습니다.

하지만 입력 이미지의 해상도가 낮으면서 세밀한 정보가 많이 포함된 이미지 데이터가 많아질 수록 모델은 환각현상을 학습하게 됩니다. 때문에 입력 이미지의 주석이 나타내는 세밀함과 그 세밀한 정보를 처리할 수 있는 모델의 능력 사이의 균형이 잘 맞아야 합니다. 이는 이후 환각현상에 대한 연구에 도움이 될 수 있겠습니다.

5.3. Compositional Capabilities

LLaVA-1.5는 각 작업을 따로 학습했지만, 명확한 프롬프트 명시 없이도 그 작업들을 조합하여 해결해야 하는 문제도 해결할 수 있게 되었습니다. 대표적으로 다음과 같은 특징들이 있습니다.

- ShareGPT 데이터셋을 포함한 뒤 시각적 대화에서 다국어 응답 성능이 향상되었습니다.

- 학술 과제 중심의 시각 데이터셋을 추가함으로써, 모델의 시각적 대화 응답이 더 정확해졌습니다.

조합적 작업 중 일부는 아직 와전히 수행하지 못하는 것도 있습니다. 예를 들어 VQA의 특정 개체에 대해서는 자세한 묘사를 하지만 전체 이미지를 설명할 때는 묘사를 누락한다거나, 한국어와 같은 특정 언어에서 응답을 제대로 하지 못하는 경우가 있습니다.

이러한 특징들은 LMMs를 개선할 때 굳이 모든 조합의 작업 유형을 학습시킬 필요가 없을 수 있다는 점을 시사합니다.

6. Conclusion

본 연구는 간단하면서도 효과적인 LMM 모델 LLaVA-1.5를 소개했습니다. 또한 기존의 열린 문제들이었던 visual instruction, 고해상도 이미지 처리, 조합적 수행능력 등에 대한 이슈에 대해 논하였습니다. 이렇게 제안한 방식이 향후 LMM 연구를 위한 기준점이 될 수 있기를 희망한다고 합니다.

Limitations

- 고해상도 이미지 학습 시에는 학습 시간이 오래 걸림.

- 다중 이미지(multiple images) 이해에 한계가 있음.

- 특정 분야(예: 복잡한 문제 해결 능력)에서는 여전히 제한된 성능을 보임.

- 환각(hallucination) 문제로부터 완전히 자유롭지 않음.